Speicherlösungen für anspruchsvolle Aufgaben

Intel bietet nicht nur Prozessoren, sondern beispielsweise auch Speicherlösungen für besonders anspruchsvolle Anforderungen. Wir stellen Ihnen in dieseraktuellen Ausgabe unseres Datacenter-Newsletters die Optionen und die vielfältigen Einsatzmöglichkeiten vor.

Wissen Sie genau, welche Cloud Services Ihr Unternehmen nutzt, wie gut diese ausgelastet sind und was sie kosten? Der FinOps Service von Computacenter bietet Ihnen eine umfassende Analyse und Optimierung Ihrer Public-Cloud-Nutzung und zeigt Ihnen mögliche Einsparpotenziale auf.

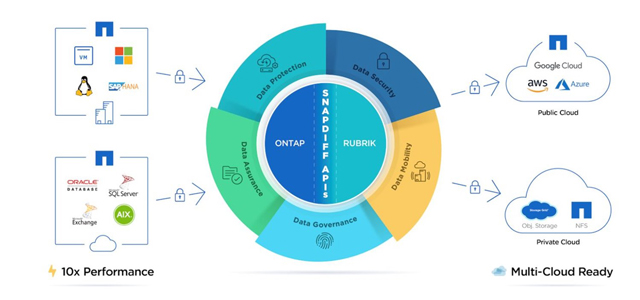

Rubrik bietet moderne Datensicherungslösungen – auch für die Hybrid und Multi-Coud. Wir zeigen Ihnen, wie ein solches Rundum-Paket inklusive Ransomware Protection und Datenmanagement aussieht.

Ein gutes Backup/Restore-Konzept zu erstellen, ist kein Hexenwerk. Lesen Sie in unserer aktuellen Backup-Kolumne, worauf dabei zu achten ist und wie sich diese Aufgabe mit einer passenden Aufgabenverteilung im Nu meistern lässt.

Viele Softwarepakete setzen heutzutage auf Open-Source-Komponenten auf und durchlaufen eine Lieferkette, die zunehmend für Angriffe verwendet wird. Damit wird das Thema sichere Software Supply Chain immer wichtiger. Mehr darüber erfahren Sie in unserer aktuellen Agile-IT-Kolumne.

Wie immer freuen wir uns über Ihr Feedback, damit wir die Schwerpunkte aufgreifen können, die für Sie von Interesse sind.

Herzliche Grüße

Markus Kunkel

Group Partner Management

Computacenter ist mit dem Dell Technologies Partner of the Year Award für Nordamerika ausgezeichnet worden. Mit dieser Auszeichnung ehrt der Hersteller außergewöhnliche Partner und deren Engagement.

Weitere InfosDie Computacenter plc. hat ihre Geschäftsergebnisse für das Jahr 2021 bekannt gegeben. Demnach stieg der Umsatz in Deutschland bei konstanten Wechselkursen um 11,6 Prozent auf 2,352 Milliarden Euro (2020: 2,108 Milliarden Euro). Dieser Anstieg war auf ein Umsatzwachstum in allen drei Geschäftsbereichen zurückzuführen.

Weitere Infos

Beim Hersteller Intel denken die meisten zuerst an Prozessoren. Das Unternehmen bietet aber beispielsweise auch Speicherlösungen für besonders anspruchsvolle Anforderungen – je nach Einsatzgebiet als Intel Optane Memory oder Intel Optane Flash.

Bei Optane Memory handelt es sich um spezielle Module, die in den RAM-Slot eines Servers eingesetzt werden. RAM – also der Hauptspeicher beziehungsweise Arbeitsspeicher – ist eine kritische Komponente in modernen Rechenzentren. Die RAM-Anforderungen wachsen stetig und die Preise steigen in astronomische Höhen, wenn richtig viel Arbeitsspeicher benötigt wird. Wie passt nun Intel Optane Memory in dieses Bild?

Intel Optane Memory wird neben „normalen“ RAM-Modulen in modernen Servern betrieben. Dafür benötigt man Intel-Xeon-Prozessoren der zweiten oder dritten Generation. (Hier kommen also auch wieder die Prozessoren ins Spiel.). Diese Optane-Memory-Module existieren mit 128, 256 oder 512 GB Kapazität. Handelt es sich demnach nur um größere RAM-Module? Mitnichten! Ein RAM-Modul wird als flüchtiger Speicher bezeichnet, da dieser ohne Spannung seine Inhalte nicht dauerhaft speichern kann. Das ist bei Optane Memory ganz anders. Hierbei handelt es sich um einen nicht-flüchtigen Speicher. Beim Einsatz von Optane Memory werden die verbauten RAM-Module als Cache verwendet. Somit ist es möglich, sehr viel Arbeitsspeicher zu relativ geringen Kosten in den Servern zu verbauen, diesen also kostengünstig zu erweitern.

Bei den Intel-Optane-Flash-Komponenten der Baureihe P4800X und P5800X handelt es sich um die schnellsten Flash-Geräte der Welt. Diese gibt es in unterschiedlichen Bauformen und Kapazitäten. Die P4800X gibt es mit 375 GB und 750 GB, die neuere Baureihe P5800X mit 400 GB, 800 GB, 1.6 TB und 3.2 TB. Das Besondere an diesen Optane-Flash-Modulen ist, dass sie sich für High-Performance-Bereiche eignen, bei denen kompromisslose Leistung erforderlich ist. Die Modellreihe P5800X ist mit PCIe 4.0 angebunden und ermöglicht atemberaubende Leistungswerte: 7 GB/s an Durchsatz und 1.5 Millionen IOPS lesend und schreibend! Aber wofür benötigt man solche High-End Performance?

Im Datacenter-Bereich ist die Antwort schnell gefunden: VMware vSAN Caching! Bei der HCI-Lösung vSAN von VMware werden zwei Storage-Bereiche definiert: Cache und Capacity. Für den Cache-Bereich, aus dem die Leistung des vSAN zustande kommt, wird das Schnellste und Beste gewählt, das man bekommen kann: Intel Optane Flash! Für den Capacity-Bereich kommen kostengünstige Read-Intensive SSDs zum Einsatz, da es dort nicht so sehr auf die Leistung ankommt.

Weitere Einsatzgebiete für Intel Optane Flash Devices sind beispielsweise High-End Workstations, bei denen es auf schnelle Reaktionszeiten und hohen Durchsatz ankommt: CAD-Konstruktionsmaschinen, Video-Rendering Workstation, Photo-Editing Systems und so weiter.

Die Einsatzgebiete sind vielfältig, wir beraten Sie gern. Kommen Sie einfach auf uns zu, dann zeigen wir Ihnen in Sizing Workshops die zahlreichen Möglichkeiten, die Intel Optane Memory und Intel Optane Flash Ihnen bieten.

Public Cloud Services sind praktisch, schnell verfügbar und meist unkompliziert zu buchen. Das hat jedoch den Effekt, dass häufig unkontrolliert Services eingekauft werden, die das Unternehmen nicht oder nicht in dem gebuchten Umfang benötigt. Damit sind die Kosten für die Cloud-Nutzung oft deutlich höher, als sie sein müssten. Der FinOps Service von Computacenter hilft, die Cloud-Nutzung zu optimieren und die Kosten zu senken.

Ein umfassender Ansatz zur Kostenkontrolle in der Cloud – so lautet die Definition von FinOps. Dabei bedeutet „umfassend“ tatsächlich, dass viele Aufgaben von vielen Funktionen innerhalb einer Organisation bearbeitet werden müssen. FinOps ist keine einzelne Aufgabe, sondern betrifft finanzielle Aspekte ebenso wie die Zusammenarbeit von Einkauf, Finanzen und Cloud-Nutzern, technische Grundlagen sowie die grundsätzliche Einstellung zum Thema „Kostenoptimierung“.

Schlussendlich geht es darum, Entscheidungen über die optimale Cloud-Nutzung in „Echtzeit“ treffen zu können und damit die Optimierung der Cloud-Nutzung als ständigen Prozess bewusst zu machen und zu etablieren. Die Reduktion auf ein Analysetool, das ein bestimmtes Preismodell für einen Workload vorschlägt, wird dem FinOps-Ansatz bei Weitem nicht gerecht.

Natürlich ist ein leistungsfähiges Werkzeug notwendig, um die Cloud-Nutzung detailliert zu analysieren. Ebenso wichtig ist auch das Verständnis der Optimierungsmöglichkeiten, die Integration der Optimierungsprozesse in die Kostenverrechnung oder die Schaffung eines unternehmensweiten Zielbildes: Ständige Verbesserungen zu erreichen, muss ein erstrebenswertes Ziel für jeden innerhalb der Organisation werden. Dementsprechend wichtig sind die Grundsätze für die Einführung einer FinOps in einem Unternehmen:

Um Unternehmen die Kontrolle der Public-Cloud-Nutzung zu ermöglichen, hat Computacenter den „FinOps Service“ entwickelt. Dieser Service ist eine Möglichkeit für Unternehmen, die FinOps-Prinzipien einzuführen und damit langfristig zum Erfolg des Unternehmens beizutragen.

Der Service umfasst unter anderem:

Dies ist eine Auswahl der möglichen Unterstützung durch unseren FinOps Service. Durch das Prüfen von Nutzungsmustern und ein umfassendes, tagesaktuelles Reporting lassen sich verlässliche Prognosen über die Entwicklung der Kosten treffen, sodass die Budgetplanung vereinfacht wird. Auch eine Alarmierung ist möglich, wenn die Kosten einen vorher festgelegten Wert überschreiten, sodass gegengesteuert werden kann. Vor allem das Rightsizing und die Automation von Prozessen tragen dann dazu bei, die Kosten für die Cloud-Nutzung dauerhaft zu senken.

Mit dem FinOps Service von Computacenter erhalten Unternehmen einen umfassenden Überblick über die genutzten Cloud Services, über die damit verbundenen Kosten sowie über mögliche Einsparpotenziale. Unternehmen können somit die Kosten für die Public-Cloud-Nutzung optimieren, ohne die Agilität, Flexibilität und Innovationsmöglichkeiten der Public Cloud einzuschränken. Aber der Service kann auch neue Möglichkeiten für eine Cloud-Nutzung offenbaren, mit der sich strategische geschäftliche Ziele – etwa eine höhere Produktivität, reduzierte Kosten oder höhere Qualität – erreichen lassen. Kurzum: Sie erhalten mit dem FinOps Service die Unterstützung von Experten, um Ihre Cloud-Nutzung zu optimieren und dabei jederzeit einen aktuellen, umfassenden, verlässlichen Überblick über die Kosten zu behalten – sowie mögliche Einsparpotenziale auszuschöpfen.

Interessiert? Dann melden Sie sich am besten gleich bei Ihrem Ansprechpartner bei Computacenter.

Moderne Datensicherungslösungen müssen vielfältige Anforderungen erfüllen. Mit Rubrik steht eine umfassende und vielseitige Lösung bereit, die jede ihr gestellte Aufgabe spielend meistert.

Die Kernaufgabe von Datensicherungslösungen – eine schnelle und effiziente Sicherung und Wiederherstellung der Daten zu ermöglichen – ist nach wie vor dieselbe. Die Datenmengen sind jedoch ebenso gewachsen, wie die Akzeptanz für längere Ausfallzeiten gesunken ist. Zudem muss eine Datensicherungslösung auf der Basis von Recovery Time Objective (RTO) und Recovery Point Objective (RPO) anpassbare SLAs ebenso unterstützen wie eine Desaster Recovery und die Langzeitaufbewahrung der Sicherungen.

Herausforderungen für Datensicherungslösungen

Die meisten IT-Infrastrukturumgebungen haben sich mit der Zeit weiterentwickelt und bilden nun statt des reinen On-Premises-Betriebs einen hybriden Ansatz ab. Dabei werden Teile oder gar ganze Bereiche in die Cloud verlegt und dort intelligent verwaltet. Besonders die Datenablage für persistente große Datenblöcke – wie Backups und kalte Daten – werden gern in Objektspeichern gespeichert. Der große Vorteil von Objektspeichern ist unter anderem die einfache Anbindung über eine gesicherte S3-Schnittstelle, welche in der Cloud oder im eigenen Datacenter zur Verfügung gestellt werden kann.

Die Datensicherungslösung muss einen sehr hohen Schutz gegen Ransomware- und andere Attacken bieten. Dazu muss sie so konzipiert sein, dass ein Abgreifen ebenso wie eine Löschung oder Veränderung der Daten – beispielsweise im Rahmen eines Angriffs oder durch Bedienfehler – möglichst verhindert wird. Hierzu sind interne Mechanismen in der Datensicherungsinfrastruktur nötig, die einen umfassenden Schutz der gesicherten Daten bieten. Dies beinhaltet zum einen Mehrfachdatenhaltung mit effizienten Replikationsmechanismen, beispielsweise auf Basis von Daten-Deduplizierung oder Auslagerung in abgetrennte Speichersysteme (Object Storage) und den Schutz der Daten in jeder einzelnen Datenablage. Dabei sind die Daten sowohl gegen direkte Manipulation auf Betriebssystem- und Dateisystemebene als auch gegen vorzeitige Löschung über die Datensicherungs-Software zu schützen. Rubrik bietet all das, fokussiert sich aber natürlich nicht nur auf den Themensektor Datensicherungslösung, sondern bietet noch vieles mehr im Hinblick auf das Speichern von Datenbeständen.

Rubrik bietet für Filesharing-Daten auf NetApp Fileshares mit der Integration von NetApp SnapDiff eine effiziente Lösung zur schnellen Identifizierung und Sicherung geänderter Dateien. Die NetApp-Systeme protokollieren dabei die Änderungen in den NAS-Shares als Basis für die Incremental-Forever-Sicherungen über Rubrik. Rubrik unterstützt hier die auf SnapMirror Cloud basierende hocheffiziente Sicherung von Fileshares über SnapDiff v3 direkt auf S3-kompatible Speichersysteme. Während die Datenübertragung unmittelbar vom NetApp-System zum S3-Speicher – beispielsweise auf Basis von NetApp StorageGrid oder cloudbasiertem S3-Speicher – erfolgt, sorgen Rubrik Polaris und Rubrik Cloud Data Management (CDM) für die sichere Orchestrierung, Indizierung und Verwaltung der Sicherungen.

Für die Sicherung der gängigen Virtualisierungsplattformen (VMware, Hyper-V) und datenführenden Applikationen – wie beispielsweise MS SQL, Oracle und SAP/HANA ebenso wie NoSQL-Datenbanken – werden bei Rubrik „klassisch“ die jeweiligen Schnittstellen der Plattformen verwendet, um eine zu den Vorgaben der Plattformhersteller konforme konsistente Sicherung herbeizuführen. Geo-Redundanz der gesicherten Daten lässt sich durch Replikationen zwischen Clustern realisieren. Für die Sicherung von Edge-Umgebungen und Remote Branches können lokale Einzelknoten als Backup Cache und Restore Cache an einem zentralen Cluster angebunden und die Sicherungen auf diesen repliziert werden. Einer einfachen und schnellen Integration in bestehende IT-Infrastrukturen steht also nichts im Wege.

Noch nie war eine Datensicherungslösung so vielseitig und angepasst an die aktuellen Datacenter-Anforderungen. Von einer umfassenden Ransomware Protection bis hin zur Anbindung an die Public Cloud über gängige und sichere Protokolle – Rubrik hat die passende Lösung im Portfolio.

Möchten Sie mehr über die Möglichkeiten von Rubrik erfahren? Wir beraten Sie gern. Melden Sie sich am besten gleich bei Ihrem Ansprechpartner bei Computacenter.

Die Einführung von neuen Produkten oder Applikationen in regulierten Umgebungen erfordert ein Backup/Restore-Konzept. Dies ist ein Meilenstein beziehungsweise Quality Gate und muss eine Handvoll vorgegebener Punkte umfassen. In der Praxis stellt dies die Produkt- und Applikationsteams vor große Herausforderungen. Wir bringen Licht ins Dunkel.

Applikations- und Produktteams führen bei Kunden neue Applikationen und Produkte ein. Diese müssen den Anforderungen der Regulatorik genügen. Im Kontext der Finanzindustrie sind dies beispielsweise die Vorgaben der BAFin als zuständige Aufsichtsbehörde. Diese publiziert eine Reihe von Anforderungen, aus denen sich auch konkrete Vorgaben an die Datensicherung ableiten. Konkret sind hier zwei Dokumente relevant: die Guidance on outsourcing to cloud service providers und die BAIT. Aus der BAIT ergibt sich aus Punkt 8.7 die Anforderung an ein Konzept für die Datensicherung. Aus dem zweiten Dokument werden die Anforderungen bis hin zu einer Auditierbarkeit formuliert, wenn beispielsweise Outsourcing-Anbieter wie Cloud Service Provider verwendet werden.

Insgesamt bedeutet dies, dass vor einem Produktionsstart eine getestete Datensicherung für die Applikation beziehungsweise das Produkt vorliegen muss. Bei einem organisatorischen Modell mit Produktverantwortlichen und Zuständigkeiten für die Applikation von der Entwicklung bis in die Produktion ist daher auch an die Datensicherung zu denken und deren Umsetzung ist ein fester Bestandteil der Aufgaben bis zur Produktivsetzung.

Wie aber gehen die Applikationsteams damit in der Praxis um?

Der erste Ansatz ist häufig eine Delegation der Zuständigkeit. Applikationsteams formulieren ihre Anforderungen an Plattform- und Infrastrukturteams und dort wird pauschal die Verantwortung für die Datensicherung als Vorgabe an die Teams formuliert.

Das ist einerseits nachvollziehbar und verständlich. Aber wenn eine Konzeption für die Applikation erstellt wird und die Zuständigkeiten definiert werden, ergeben sich fast immer Zuständigkeiten in den Applikationsteams – woran eine solche Delegation häufig scheitert. Das begründet sich in einer Reihe von Punkten – unter anderem sind dies:

Diese zwei Beispiele zeigen auf, dass Applikationsteams in der Konzeption, Umsetzung und bei den Regeltätigkeiten der Datensicherung eingebunden sein müssen. Damit wird es notwendig, ein Backup/Restore-Konzept (B/R-Konzept) zu formulieren und eine Delegation ist nicht oder nur teilweise möglich.

Daraus resultiert eine Story im Backlog beziehungsweise in der Aufgabenliste des Applikationsteams, ein Datensicherungskonzept zu formulieren. Wie wir aus mehrjähriger Erfahrung mit verschiedenen Kundensituationen wissen, ist diese Aufgabe meist ausgesprochen unbeliebt und die Umsetzung dauert daher häufig recht lange. Man könnte vielleicht sagen, dass die Applikationsteams einen gehörigen Respekt vor der Story haben. Dabei ist ein B/R-Konzept eigentlich eine einfache Aufgabe, da nur eine Reihe von Fragen zu formulieren und zu beantworten sind und diese beispielsweise im IT-Grundschutzkompendium des BSI vorformuliert sind.

Etwas komprimiert adressieren die Fragen die folgenden Punkte:

Dies ist ein Auszug der möglichen Anforderungen. Diese werden durch Vorgaben der IT-Sicherheit – zum Beispiel Verschlüsselung – ergänzt.

Wenn Applikationsteams in einem B/R-Konzept die Antworten zu diesen Fragen beschreiben, ist das B/R-Konzept in wesentlichen Teilen fertiggestellt. Die technische Umsetzung und Testverfahren lassen sich anschließend definieren und können dann auch zwischen den Applikations- und Plattform- beziehungsweise Infrastrukturteams abgestimmt werden.

Im Kern ist das Erstellen eines Konzepts für die Datensicherung einfach, wenn die notwendigen Fragestellungen beantwortet werden. In der Praxis zeigt sich jedoch häufig ein gehöriger Respekt oder eine Distanz zu der Datensicherung. Das kann auch auf Fragestellungen rund um Hochverfügbarkeit und Desaster Recovery (HA/DR) sowie konkrete Anforderungen an die Speicherplattform ausgedehnt werden.

Es bietet sich daher an, die Applikationsteams proaktiv zu unterstützen und ihnen zu zeigen, wie eine Konzeption aufgebaut und befüllt werden sollte.

In der Realität findet eine solche proaktive Zusammenarbeit selten statt. Es bildet sich beispielsweise ein Dreigestirn aus Applikations-, IT-Sicherheits- und B/R-Team und alle Teams haben intern die Anforderungen beziehungsweise die technischen Lösungen definiert. Aber diese müssen zusammengebracht und die Zuständigkeiten geklärt und gelebt werden.

Für manche mag Datensicherung kein spannendes Thema sein. Aber sie ist eine Notwendigkeit und ein Punkt, der im Rahmen der Regulatorik betrachtet werden muss. Und ein Datensicherungskonzept kann schnell gemeinsam abgearbeitet werden – weil es ansonsten gerne als eine Story im Backup ist, die lange vor sich hergetragen wird.

Haben Sie Fragen zum Backup/Restore-Konzept? Wir unterstützen Sie gern!

Unternehmen investieren einen erheblichen Aufwand, die Produktion abzusichern. Dabei laufen in den Produktionsumgebungen Software-Pakete, die über eine Lieferkette, häufig beginnend mit Open Source Communities, bereitgestellt werden und die zunehmend für Angriffe verwendet wird. Dies hat das Thema „sichere Software Supply Chain“ prominent auf die Agenda der Open Source Communities und Unternehmen gehoben.

Software bildet den Kern der Applikationen und unternehmenskritischen Anwendungen. Open Source bildet wiederum den Kern dieser Software.

In diesem Kontext ist es zwingend erforderlich, den Entwicklungsprozess insgesamt zu betrachten und die intensive Verwendung von Open Source Software (OSS) zu berücksichtigen. OSS nimmt heute weltweit in der Software-Entwicklung bis hin zur produktiven Verwendung der daraus erstellen Applikationen einen erheblichen Anteil ein, nämlich 60 bis 80 Prozent. Moderne Anwendungen und deren Verwendung auf Benutzergeräten (Smartphone, Automobile, andere) über Rechenzentren und Public-Cloud-Strukturen bis hin zu der Softwareentwicklung nutzen OSS, um effizienter, wirtschaftlicher und schneller Lösungen und Angebote zu entwickeln und bereitzustellen.

Das bedeutet für Unternehmen, welche OSS in der eigenen Softwareentwicklung einsetzen oder Applikationen einkaufen, die heute fast alle einen hohen Anteil an OSS-Komponenten beinhalten, dass sie Vorgaben definieren und den Umsetzungsprozess nach festen Regeln gestalten müssen, um sichere und vertrauenswürdige OSS einzusetzen. Das gilt auch für kommerzielle Fremdsoftware (Softwareprodukte), da die Sicherheitsanforderungen grundsätzlich für jede Software gelten und kommerzielle Software OSS-Komponenten enthält.

Während der überwiegende Teil der Open Source Communities und der Entwickler, teilweise aus persönlicher Überzeugung, OSS entwickeln, finden sich auch hier Menschen, die mit krimineller Energie versuchen, daraus persönliche Vorteile zu erzielen. Dazu sind viele Vorfälle und Angriffsvektoren aus den letzten Jahren dokumentiert, ein aktueller Fall im Jahr 2021 war beispielsweise die Log4j-Problematik.

All das führt dazu, dass sich in vielen Unternehmen ein Riss zwischen der Softwareentwicklung und der zentralen IT gemeinsam mit den IT-Sicherheitsteams bildet. Entwickler wollen innovativ und einfach neue Ideen und Unternehmenswerte durch neue Applikationen generieren, während die zentrale IT auf stabile, sichere und getestete Lösungen pocht. Beide Sichtweisen sind aus Unternehmenssicht wichtig und zwingend notwendig, um schnell auf Änderungen in den Vorgaben reagieren und diese sicher umsetzen zu können. Softwareentwickler sehen solche Vorgaben für eine sichere und stabile Produktion jedoch häufig als restriktiv und zeitraubend an.

Um diesen Kluft zu beheben, müssen den Entwicklern und Softwarebeschaffenden Lösungen und Prozesse an die Hand gegeben werden, um die Vorgaben einfacher und schneller zu erreichen. Dazu dienen Service-Angebote, mit denen Entwickler effizienter und einfacher arbeiten können und in denen die Sicherheit und produktive Stabilität integriert ist.

Speziell im Kontext der sicheren Softwareentwicklung ist hierfür die Grundlage ein Service, welcher die gesamte Kette von Open Source Repositories in den Communities über die Softwareentwicklung bis hin zur Produktivsetzung und der Abschaltung von Software-Code am Ende des Lebenszyklus beziehungsweise bei neuen Versionen der Software bedient. Dies wird in den aktuellen Diskussionen in den Governance-Gremien (Beispiel ist die Supply Chain Security-Initiative) in der Open Source Community unter den Begriffen Software Supply Chain sowie Supply Chain Security betrachtet. Im September 2022 wird sich ein eigener Arbeitskreis im Rahmen des europäischen Open Source Summits unter der Kategorie Critical Software Summit mit diesem Thema befassen, aber bereits heute beschäftigen sich fortlaufend Experten damit.

Eine Software Supply Chain umfasst eine Reihe von Bausteinen. Einer davon kommt sehr früh zum Tragen und besteht darin, Open Source Software eindeutig zu identifizieren und zu kennzeichnen. Damit befassen sich beispielsweise Projekte wie sigstore.dev, die eine Technologie bereitstellen, um Software eindeutig identifizieren und zuordnen zu können. Die hohe Akzeptanz solcher Projekte zeigt die Relevanz und Notwendigkeit dieses Schrittes auf. Allerdings sind neben einem solchen rein technischen Verfahren weitere Bausteine für eine sichere Software Supply Chain erforderlich.

Eine eindeutige Identifikation sagt beispielsweise nichts darüber aus, ob die Software aktiv weiterentwickelt wird, ob also neue Versionen und Sicherheits-Updates entstehen. Damit müssen auch Themen wie Aktivitäten in den Projekten, Bereitstellung neuer Versionen und der Lifecycle betrachtet werden, worunter unter anderem fällt, wie alte Versionen aus laufenden Softwareanwendungen entfernt und modernisiert werden.

Das erfordert neben den technischen Aspekten auch:

Die Supply Chain für Software ist auch in den Fokus von Regulierungsbehörden gerückt und es ist abzusehen, dass zunehmend strengere Vorgaben und Anforderungen gestellt werden. Diese Anforderungen sind zwar aufzunehmen und umzusetzen – aber es sollte mehr der Nutzen in den Vordergrund gestellt werden.

Heute wird im Rahmen der Softwareentwicklung und meistens durch die verschiedenen individuellen Teams die Supply Chain nach bestem Wissen umgesetzt. Das bindet über mehrere Teams hinweg Ressourcen und Kapazitäten, die effizienter für die Weiterentwicklung von Anwendungen und Lösungen eingesetzt werden sollten.

Durch den Aufbau eines Services für die Software Supply Chain werden die notwendigen Aufgaben und Ressourcen konsolidiert und verschlankt und gleichzeitig die Sicherheit erhöht. Das ist ein positiver und nützlicher Aspekt.

Das Risiko wiederum besteht darin, dass ein solcher Service nicht schnell genug agiert, was zu Verzögerungen und Unzufriedenheit führen würde – sodass keine ausreichende Akzeptanz erreicht würde. Das bedeutet, der Service für die Supply Chain muss mit der gleichen Geschwindigkeit und Dynamik aufgebaut werden, wie dies in der Softwareentwicklung erfolgt. Das erfordert eine konsequente Automation, agile Vorgehensweisen und eine Tool-Landschaft, die das effizient und nach Code- und GitOps-Modellen unterstützt.

Auf Open-Source-Technologie basierende Lösungen einzusetzen und, insofern eine Softwareentwicklung im Unternehmen erfolgt – auch in der Entwicklung Open-Source-Komponenten zu verwenden, ist sinnvoll und effizient. Es erfordert jedoch, eine Software Supply Chain aufzubauen. Computacenter unterstützt bereits heute Kunden von der Konzeption über den Aufbau inklusive der Richtlinien und Prozesse bis hin zur fortlaufenden Weiterentwicklung und dem Betrieb des Services für die sichere Software Supply Chain. Sprechen Sie uns dazu gern an!